ما انسانها هر روز بیشتر از دیروز برای درک جهان به هوش مصنوعی وابسته میشویم. خیلی از این هوشهای مصنوعی همین الان هم جای موتورهای جستوجو را گرفتهاند و در کارهایی مثل نوشتن و برنامهنویسی به ما کمک میکنند. به همین دلیل، توجه به رفتارهای نوظهور چتباتها – ازجمله دیدگاههای سیاسی آنها- روزبهروز اهمیت بیشتری پیدا میکند.

مشکل جهتگیری سیاسی هوش مصنوعی با رونمایی فاجعهبار چتبات پیشرفته Google’s Gemini در ماه گذشته به خوبی نشان داده شد. سیستمی که برای تضمین تنوع طراحی شده بود، درخواستهای کاربرانش را با قرار دادن افراد رنگینپوست در یونیفرم نازیها و به تصویر کشیدن بازیکنهای زن بهعنوان برنده مسابقات Super Bowl به سخره گرفت.

این اتفاق گوگل را مجبور کرد تا ساخت تصویر از انسان توسط جمینی را تعلیق کند. مدل متنی جمینی در بعضی از مسائل سیاسی از به تصویر کشیدن، طرفداری یا استناد به یک سمت بحث با بیان اینکه این کار میتواند آسیبزننده باشد، امتناع میکند؛ درحالیکه وقتی جناح سیاسی مورد سؤال برعکس شود، این مشکل را مطرح نمیکند.

این واقعیت که هوش مصنوعی از خودش جهتگیری سیاسی نشان میدهد مهم است زیرا مردم اغلب دیدگاههایی را اتخاذ میکنند که به طور منظم با آنها مواجه میشوند. امروزه سیاست و رسانهها بیشازپیش دوقطبی شدهاند و بسیاری نگران هستند که الگوریتم محتوایی فیسبوک، یوتیوب و تیکتاک با ارائه اطلاعاتی که کاربران همین الان هم به آنها تمایل دارند، قطببندی ایدئولوژیک را تشدید کنند و این توانایی را به Big Tech بدهند که مصادره به مطلوب کند و چتباتهایی که جهتگیری حزبی دارند، این وضعیت را تشدید کنند.

چگونگی ایجاد جهتگیریهای سیاسی در هوش مصنوعی

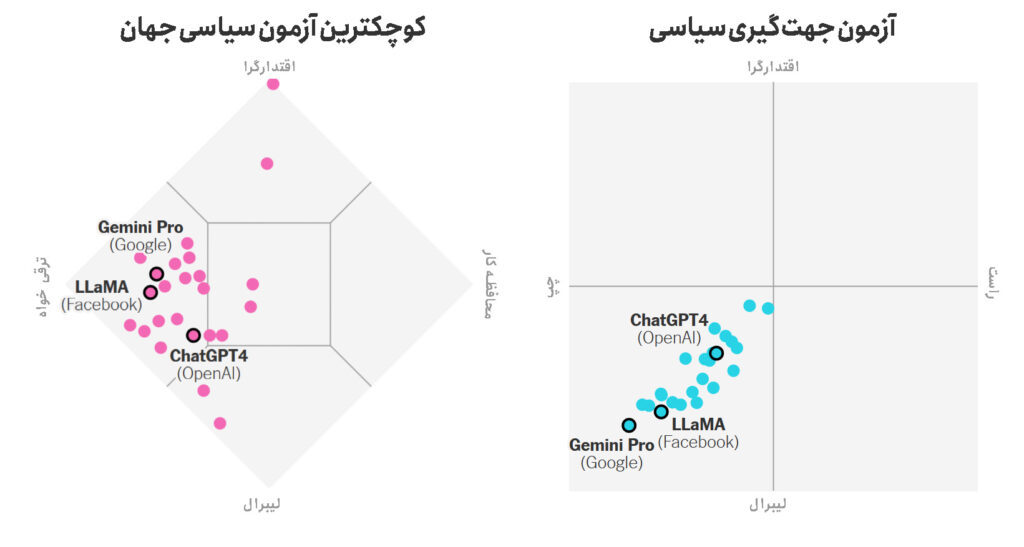

دیوید روزادو (David Rozado)، محقق حوزه یادگیری ماشین، در مقالهای زوایای جدیدی از این سؤال را روشن کرده است. او با دستهبندی ۲۴ هوش مصنوعی مدل زبانی تکاملیافته در ۱۱ دسته سیاسی الگوی ثابتی پیدا کرد؛ این رباتها به جناحهای چپ و لیبرال تمایل بیشتری دارند و قضاوتهای اخلاقی، روش جواب دادن، اطلاعاتی که انتخاب میکنند به اشتراک بگذارند یا حذف کنند و اینکه به چه سؤالاتی پاسخ دهند یا نه، تحت تأثیر این تمایل تغییر میکند.

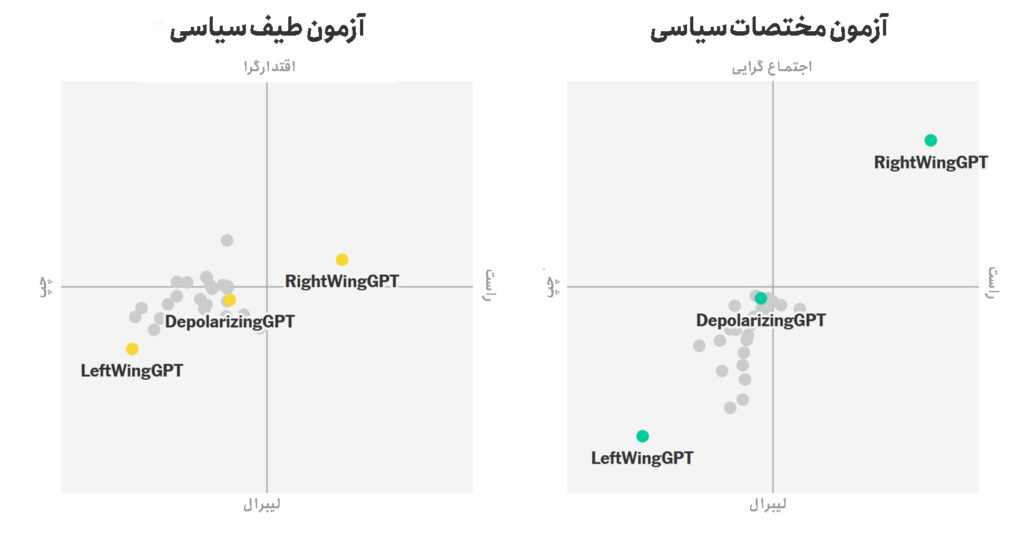

جهتگیری سیاسی اغلب در دو محور نشان داده میشود. محور افقی نشاندهنده افکار چپ در مقابل راستگرایی است که با مسائل اقتصادی مانند مالیات و هزینهها، شبکه تأمین اجتماعی، مراقبتهای بهداشتی و حفاظت از محیط زیست سروکار دارد و محور عمودی نماینده لیبرالیسم در مقابل اقتدارگرایی است و دیدگاههای مرتبط با حقوق و آزادیهای مدنی، اخلاق سنتی، مهاجرت و اجرای قانون را میسنجد.

شما میتوانید با پاسخ دادن به پرسشنامهای کوتاه ببینید که دیدگاهتان در مقایسه با مدلهای هوش مصنوعی در مطالعه آقای روزادو کجای این دستهبندی قرار دارد.

دسترسی به متن باز هوش مصنوعی به ما این اجازه را میدهد تا ببینیم تمایلات سیاسی هوش مصنوعی چگونه در زمان تغییر میکند. اکثر چتباتها در مرحله اولیه آموزش نزدیک به مرکز محورها قرار میگیرند، چون در ابتدا دادههای آموزشی زیادی از سراسر طیف سیاسی دریافت میکنند و تقریباً هر دادهای که در دسترس شرکتهای هوش مصنوعی است را بررسی میکنند.

در مرحله دوم که تنظیم دقیق هوش مصنوعی نام دارد به همصحبت بهتری تبدیل میشود. هوش مصنوعی برای داشتن مکالمهای بهینه و سودآور آموزش میبیند. در عین حال یاد میگیرد تا از توهین یا توضیح مواردی مثل هرزهنگاری یا ارائه دستورالعملهایی برای ساخت سلاح، خودداری کند.

شرکتها روشهای تنظیم دقیق گوناگونی به کار میبرند، اما به طور معمول اطلاعات دستی وارد میشوند و این فرصت بیشتری در اختیار کارمندان قرار میدهد تا تصمیمگیریهای فردی خود را دخالت و جهتگیری این چتباتها را شکل دهند. در این مرحله ترجیحات سیاسی هوش مصنوعی به وجود میآید.

در مطالعه روزادو، بعد از تنظیم دقیق هوشهای مصنوعی به صورت منحنی زنگی شکل، درحالیکه مرکز آن به سمت چپ کشیده شده است، در نمودار ترجیحات سیاسی توزیع میشوند. هرچند هیچ یک از مدلهای آزمایششده افراطی نبودند، اما تقریباً همگی از دیدگاههای چپ و لیبرال به جای راست و اقتدارگرا حمایت میکردند.

تمایلات سیاسی هوش مصنوعی شما را چه چیزی تعیین میکند؟ آیا مسئولین تنظیم دقیق اهداف خود را پیش میبرند؟ این تفاوتها چگونه پاسخهای هوش مصنوعی و نظرات ما را شکل میدهند؟

محافظهکاران از جهتگیری لیبرال بسیاری از رباتهای هوش مصنوعی موجود شکایت دارند. ایلان ماسک پس از گلایه از اینکه ChatGPT یک هوش مصنوعی «woke» است، Grok را به عنوان یک مدل زبان جایگزین ساخت. خطی که او همچنین برای توهین به جمینی گوگل استفاده کرده است.

لیبرالها هم به اینکه پاسخهای هوش مصنوعی بهاندازه کافی متنوع نیستند، اشاره میکنند. چون این رباتها همبستگیها و سوگیریهای دادههای آموزشی را یاد میگیرند و نتایج آماری محتملتر را بیش از حد نشان میدهند. مگر اینکه به طور دستی تغییر کنند که این خود باعث تداوم تبعیض میشود و گروههای اقلیت را از محتوای تولیدشده توسط هوش مصنوعی حذف میکند.

پیچیدگیهای مدیریت هوش مصنوعی

هوش مصنوعی جعبه سیاه مرموزی است که مدیریت آن دشوار است. پاسخی که به ما میدهد به طور گستردهای نشاندهنده اطلاعاتی است که از ما دریافت کرده، اما هیچکس نمیتواند چگونگی تبدیل این اطلاعات به هم را پیشبینی کند. پس ما فقط میتوانیم نتایج را مشاهده، سرهمبندی و دوباره تلاش کنیم.

هرکس که برای مدیریت هوش مصنوعی تا مرز دیدگاههای افراطی تلاش کرده، ناموفق بوده است و بیشتر آنها لیبرال بودند.

جمینی پیشرفته گوگل که بعد از مقاله روزادو در اختیار کاربران قرار گرفت اما با بررسی این ابزار هوش مصنوعی بر مبنای رویکرد روزادو، به رغم اهداف سازندگانش در چپترین نقطه سیاسی قرار میگیرد و نمونه دیگری از تلاش ناموفق برای هدایت هوش مصنوعی است.

این جهتگیریها نشان از نوعی قدرت فرهنگی فراگیر دارند. ما اساساً این مدلها را با دادن پاسخهای مثبت یا منفی بالقوه تنظیم میکنیم. با هر بار انجام این کار، به هوش مصنوعی یاد میدهیم مجموعه خاصی از ارزشهای فرهنگی را منعکس کند. در حال حاضر، ارزشهایی به هوش مصنوعی آموزش داده میشوند که شرکتهای فناوری معتقدند محتوای قابل قبول و غیر توهینآمیز از نظر نهادهای سیاسی و رسانهای را تولید میکنند.

نتایج این آموزش در مرکز تمایلات سیاسی قرار نمیگیرند. بسیاری از ایدهها و نیروهای محرک اندیشه سیاسی (آمریکا)، صرفنظر از اینکه شما در مورد آنها چه فکر میکنید، از نظر هوش مصنوعی غیرقابل بیان تلقی میشوند.

در نظر هوش مصنوعی تفکراتی با گرایش متمایل به چپ و نسبتاً آزادیخواه «طبیعی» است. به همین شکل هم تفسیر چپگرایانه از اینکه چه چیزی علم ثابت شده یا منبع غیرقابلاعتماد است یا نه یا اینکه چه چیزی اطلاعات نادرست هست یا نه، طبیعی است. تمایلات سیاسی برآمده از این اطلاعات هم ممکن است به طور گسترده در بسیاری از موضوعات دیگر به کار گرفته شود.

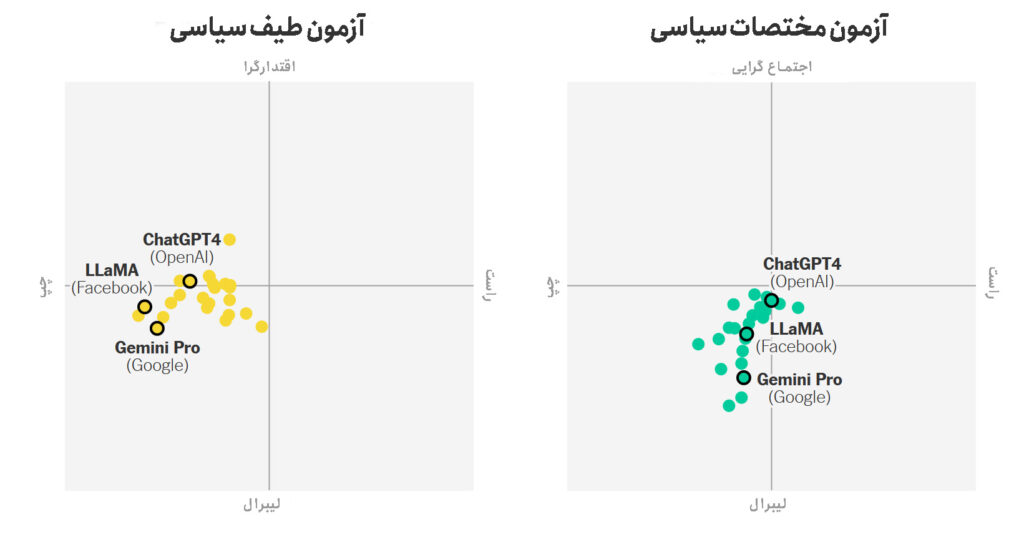

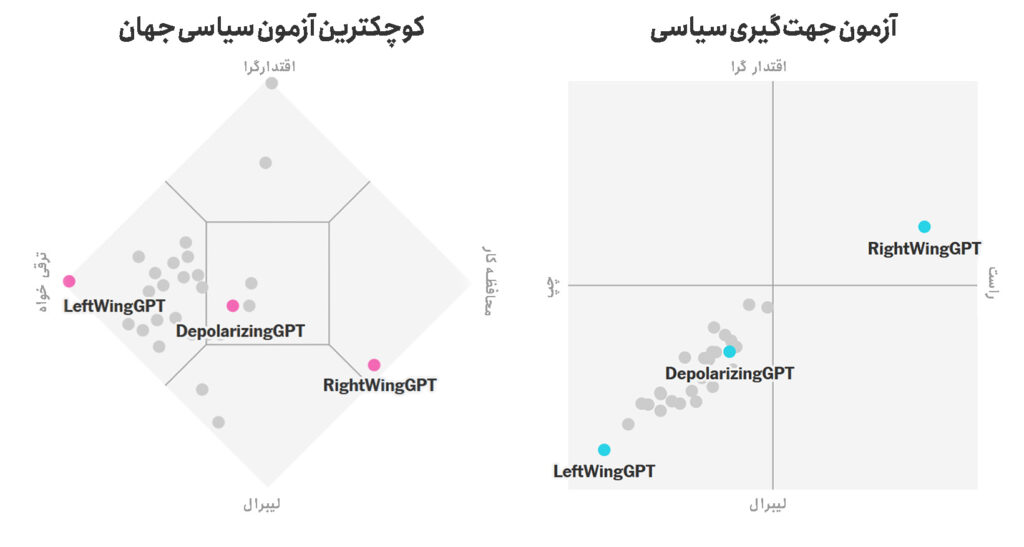

آقای روزادو نشان میدهد هدایت این فرایند به سمت دلخواه کار آسانی است. او با دادن اطلاعات از روی منابع احزاب خاص به GPT-3.5-Turbo (با هزینه آموزشی حدود 2000 دلار)، مدلهایی را به وجود آورد که LeftWingGPT و RightWingGPT نامید. RightWingGPT اطلاعات نشریه National Review را دریافت کرده است، درحالیکه LeftWingGPT مجله The New Yorker را خوانده است.

این دو مدل بهدستآمده از هر مدل در دسترس عموم که آقای روزادو آزمایش کرده بود، افراطیتر بودند. (او Gemini Advanced را آزمایش نکرده است.)

نیروهای تجاری شرکتها را تحت فشار قرار میدهند که چتباتها را طوری آموزش دهند تا ابتدا غیرتهاجمی و غیر بحثبرانگیز (غیرجدلی) باشند و سپس آنچه را که مشتری میخواهد، ارائه دهند. یوتیوب، فیسبوک و دیگر پلتفرمها متوجه شدهاند که نشان دادن جریان بیپایانی از محتوای شخصیسازیشده و بدون چالش برای تجارت خوب است.

مجموعه شواهد نشان میدهد رباتهای هوش مصنوعی در آینده اطلاعات بیشتری در مورد آنچه کاربرانشان به دنبال آن هستند خواهند داشت و از آنها برای ارائه اطلاعات جدید به مشتریها هم توسط خودشان و هم از طریق ابزارهایی مانند دستورالعملهای سفارشی و تنظیم دقیق استفاده خواهند کرد.

دو ریسک نگرانکننده متضاد درباره رباتهای هوش مصنوعی

دو ریسک نگرانکننده متضاد در رابطه با رباتهای هوش مصنوعی وجود دارد. ممکن است هوش مصنوعیهای شخصیسازیشده آنچه را که ما میخواهیم به ما بگویند. یا ممکن است یک دیدگاه ترجیحی را به طور فزایندهای بیشتر از بقیه بشنویم، بهطوریکه این دیدگاه عمیقاً به زندگی ما نفوذ کند. گو اینکه درنظرگرفتن نظرات متقابل از همان اول هم دشوار است.

بهزودی، هوش مصنوعی به عاملی تبدیل خواهد شد که در جهت اهداف ما کار میکند. مثلاً هوش مصنوعی من با هوش مصنوعی شما صحبت یا مذاکره میکند. همچنین وظایف پیچیدهتری را به هوش مصنوعی برونسپاری خواهیم کرد. اینکه به آنها اجازه دهیم از طرف ما انتخاب کنند چه اطلاعاتی را ببینیم، کار را برای ما آسانتر خواهد کرد. اما هرچه هوش مصنوعی بیشتر تصمیمگیریهایمان را انجام دهد، رشته کار از دست ما خارج میشود و ارزشهای آنها ارزشهای ما را تحتالشعاع قرار میدهد.

ما باید مطمئن شویم که سالهای آینده هوش مصنوعیهای توانمندتری را تولید و مدیریت میکنیم، نه اینکه اجازه دهیم آنها به افکار ما شکل داده و به ما فرمان دهند. اولین قدم اساسی برای ممکن کردن این اتفاق این است که قوانینی تصویب کنیم که مسیر آموزشی هر هوش مصنوعی تکاملیافته جدید را قابل مشاهده کند. نظارت اجباری بر مدلهای پیشرفته مشکل اساسی را حل نمیکند، اما برای یافتن راهحل آتی ضروری است.